Cet article a été sponsorisé par JetOctopus. Les opinions exprimées dans cet article sont celles du sponsor.

Si vous gérez un grand site Web de plus de 10 000 pages, vous apprécierez probablement les défis uniques en matière de référencement qui accompagnent une telle envergure.

Bien sûr, les outils et tactiques traditionnels – optimisation des mots clés, création de liens, etc. – sont importants pour établir une base solide et maintenir une hygiène de base en matière de référencement.

Cependant, ils ne répondent peut-être pas entièrement aux complexités techniques de la visibilité du site pour les robots de recherche et aux besoins dynamiques d'un site Web de grande entreprise.

C'est là que les analyseurs de journaux deviennent cruciaux. Un analyseur de journaux SEO surveille et analyse les journaux d’accès au serveur pour vous donner un aperçu réel de la manière dont les moteurs de recherche interagissent avec votre site Web. Il vous permet de prendre des mesures stratégiques qui satisfont à la fois les robots de recherche et les utilisateurs, ce qui entraîne de meilleurs retours sur vos efforts.

Dans cet article, vous découvrirez ce qu'est un analyseur de journaux et comment il peut permettre à votre stratégie de référencement d'entreprise d'obtenir un succès durable. Mais d’abord, jetons un coup d’œil rapide à ce qui rend le référencement délicat pour les grands sites Web comportant des milliers de pages.

Les défis SEO uniques pour les grands sites Web

La gestion du référencement d'un site Web de plus de 10 000 pages n'est pas seulement une étape supplémentaire ; c'est un tout autre jeu de balle.

S'appuyer sur des tactiques de référencement traditionnelles limite le potentiel de croissance organique de votre site. Vous pouvez avoir les meilleurs titres et contenus sur vos pages, mais si Googlebot ne peut pas les explorer efficacement, ces pages seront ignorées et pourraient ne jamais être classées.

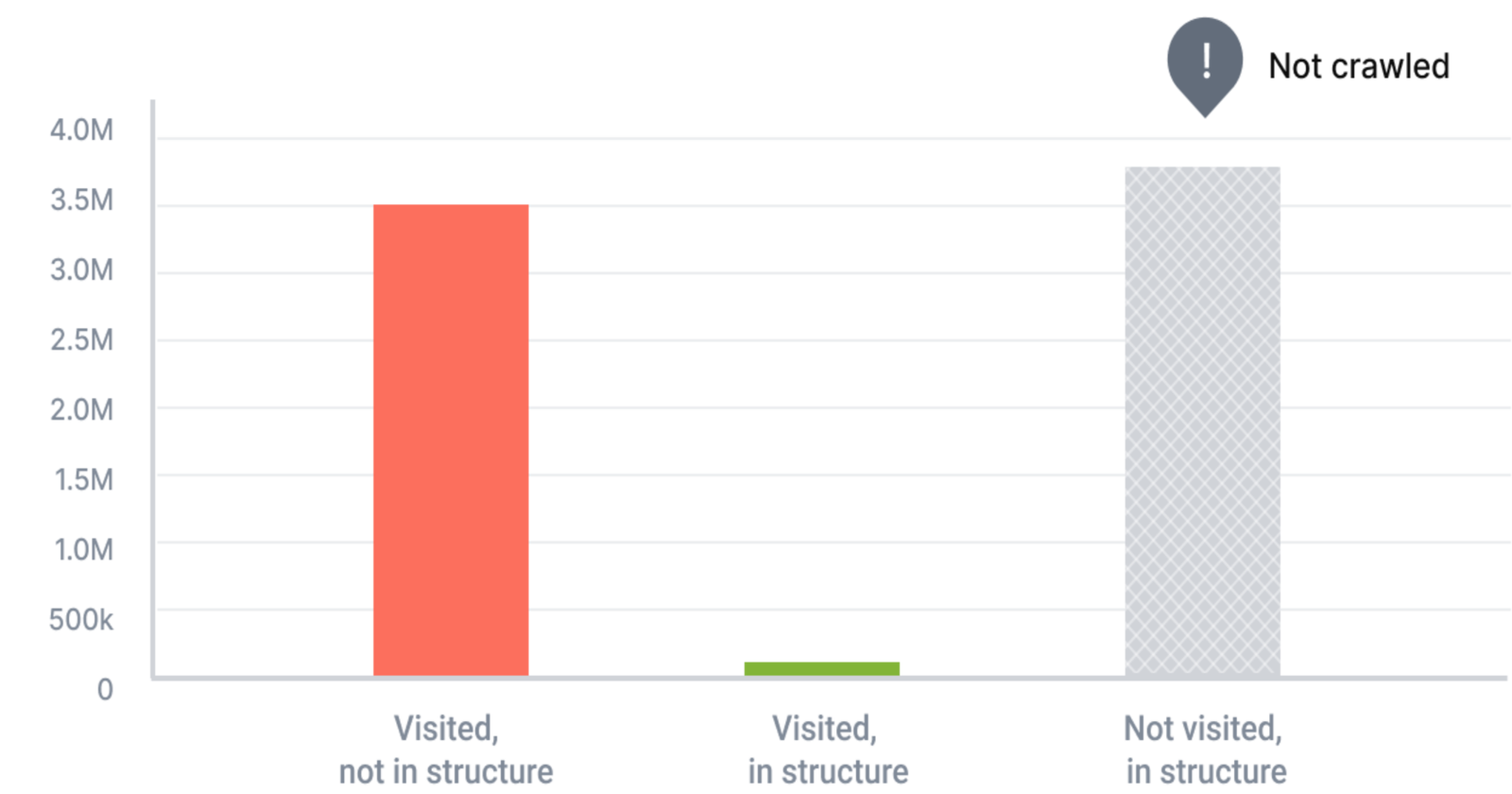

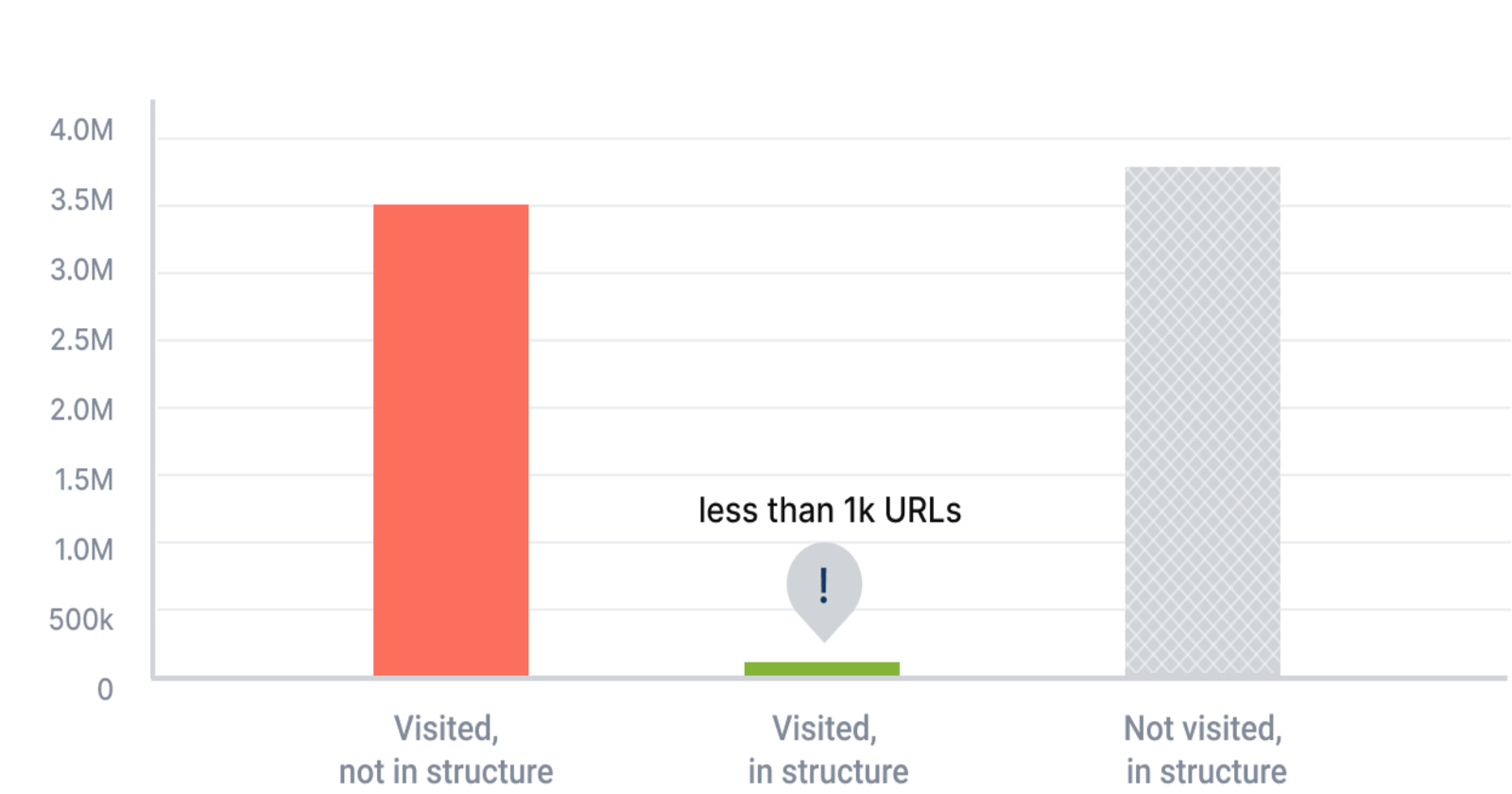

Image créée par JetOctopus, mai 2024

Image créée par JetOctopus, mai 2024 Pour les grands sites Web, le volume considérable de contenu et de pages rend difficile la garantie que chaque page (importante) est optimisée pour la visibilité de Googlebot. Ensuite, la complexité supplémentaire d’une architecture de site élaborée entraîne souvent d’importants problèmes de budget d’exploration. Cela signifie que Googlebot manque des pages cruciales lors de ses explorations.

Image créée par JetOctopus, mai 2024

Image créée par JetOctopus, mai 2024 De plus, les grands sites Web sont plus vulnérables aux problèmes techniques, tels que des ajustements inattendus du code par l'équipe de développement, qui peuvent avoir un impact sur le référencement. Cela exacerbe souvent d'autres problèmes tels que la lenteur des pages en raison d'un contenu lourd, de liens rompus en masse ou de pages redondantes qui se disputent les mêmes mots-clés (cannibalisation des mots-clés).

Dans l’ensemble, ces problèmes liés à la taille nécessitent une approche plus robuste du référencement. Celui qui peut s'adapter à la nature dynamique des grands sites Web et garantir que chaque effort d'optimisation est plus significatif vers l'objectif ultime d'améliorer la visibilité et de générer du trafic.

Ce changement stratégique est là où la puissance d’un analyseur de journaux SEO devient évidente, fournissant des informations granulaires qui aident à prioriser les actions à fort impact. L'action principale est de mieux comprendre Googlebot comme s'il s'agit de l'utilisateur principal de votre site Web : jusqu'à ce que Googlebot accède à vos pages importantes, elles ne seront pas classées et ne généreront pas de trafic.

Qu'est-ce qu'un analyseur de journaux SEO ?

Un analyseur de journaux SEO est essentiellement un outil qui traite et analyse les données générées par les serveurs Web à chaque fois qu'une page est demandée. Il suit la manière dont les robots des moteurs de recherche interagissent avec un site Web, fournissant des informations cruciales sur ce qui se passe dans les coulisses. Un analyseur de journaux peut identifier quelles pages sont explorées, à quelle fréquence et si des problèmes d'exploration se produisent, tels que l'impossibilité pour Googlebot d'accéder à des pages importantes.

En analysant ces journaux de serveur, les analyseurs de journaux aident les équipes SEO à comprendre comment un site Web est réellement vu par les moteurs de recherche. Cela leur permet d'effectuer des ajustements précis pour améliorer les performances du site, augmenter l'efficacité de l'exploration et, finalement, améliorer la visibilité SERP.

En termes simples, une analyse approfondie des données des journaux permet de découvrir des opportunités et d'identifier des problèmes qui autrement pourraient passer inaperçus sur les grands sites Web.

Mais pourquoi exactement devriez-vous concentrer vos efforts sur le traitement de Googlebot comme votre visiteur le plus important ?

Pourquoi le budget de crawl est-il si important ?

Examinons cela.

Optimiser le budget d'exploration pour un impact SEO maximal

Le budget d'exploration fait référence au nombre de pages qu'un robot d'un moteur de recherche, comme Googlebot, explorera sur votre site dans un délai donné. Une fois le budget d’un site épuisé, le robot arrêtera d’explorer et passera à d’autres sites Web.

Les budgets d'exploration varient pour chaque site Web et le budget de votre site est déterminé par Google lui-même, en tenant compte d'un certain nombre de facteurs tels que la taille du site, ses performances, la fréquence des mises à jour et les liens. Lorsque vous vous concentrez sur l’optimisation stratégique de ces facteurs, vous pouvez augmenter votre budget d’exploration et accélérer le classement des nouvelles pages et contenus du site Web.

Comme vous vous en doutez, tirer le meilleur parti de ce budget garantit que vos pages les plus importantes sont fréquemment visitées et indexées par Googlebot. Cela se traduit généralement par un meilleur classement (à condition que votre contenu et votre expérience utilisateur soient solides).

Et c'est ici qu'un outil d'analyse de journaux se révèle particulièrement utile en fournissant des informations détaillées sur la manière dont les robots d'exploration interagissent avec votre site. Comme mentionné précédemment, il vous permet de voir quelles pages sont explorées et à quelle fréquence, ce qui vous aide à identifier et à résoudre les inefficacités telles que les pages de faible valeur ou non pertinentes qui gaspillent de précieuses ressources d'exploration.

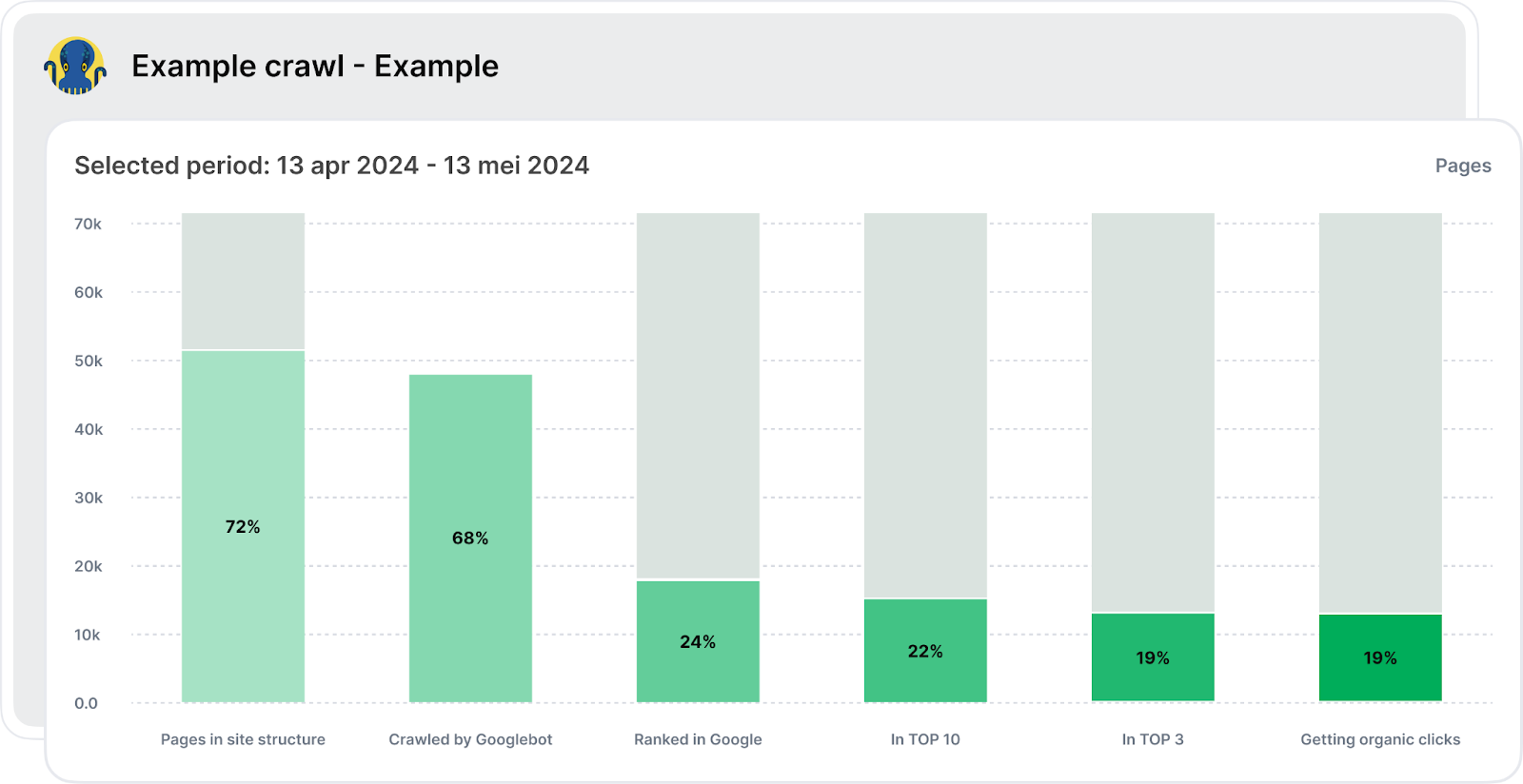

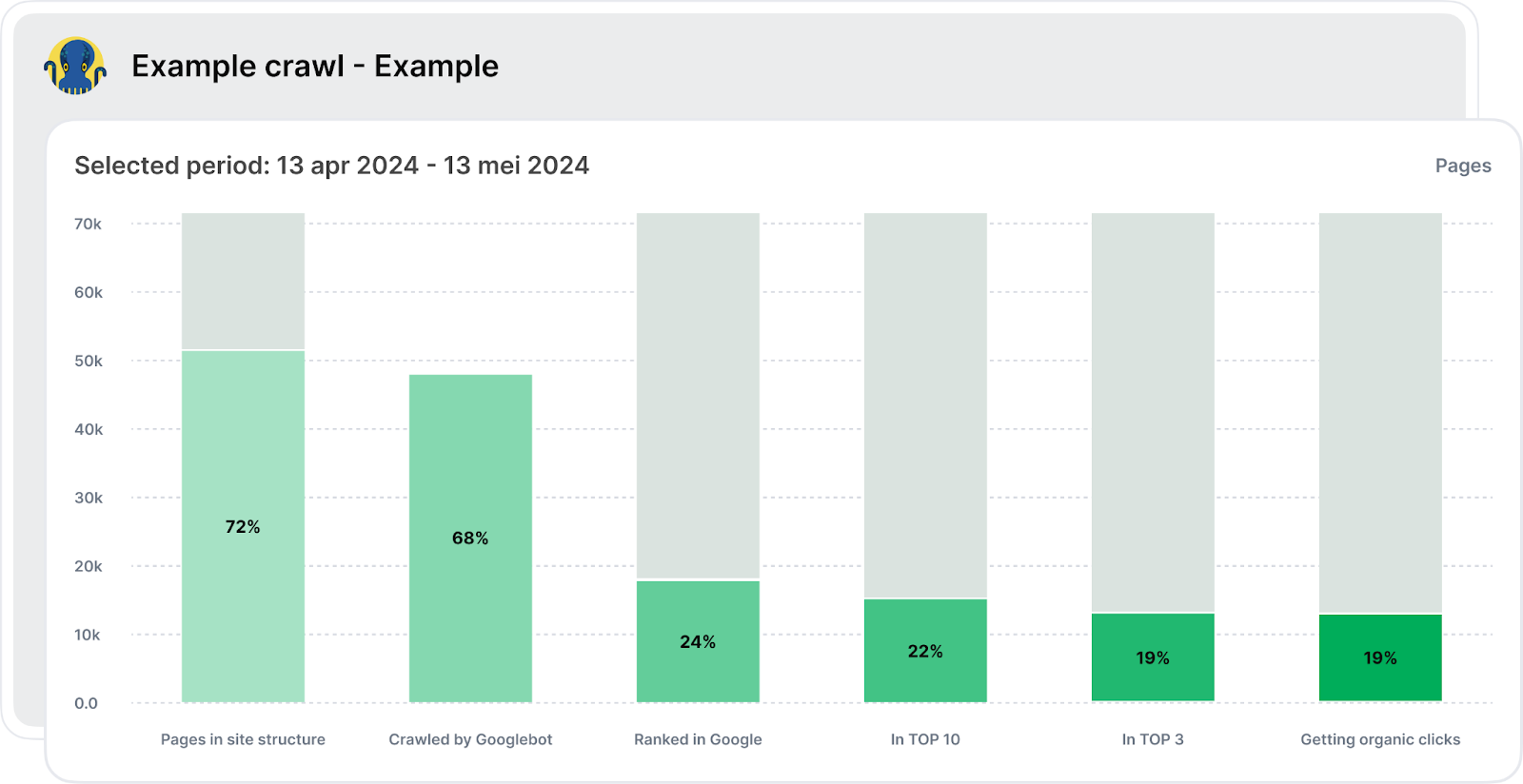

Un analyseur de journaux avancé comme JetOctopus offre une vue complète de toutes les étapes, depuis l'exploration et l'indexation jusqu'à l'obtention de clics organiques. Son entonnoir SEO couvre toutes les étapes principales, de la visite de votre site Web par Googlebot au classement dans le top 10 et à la génération de trafic organique.

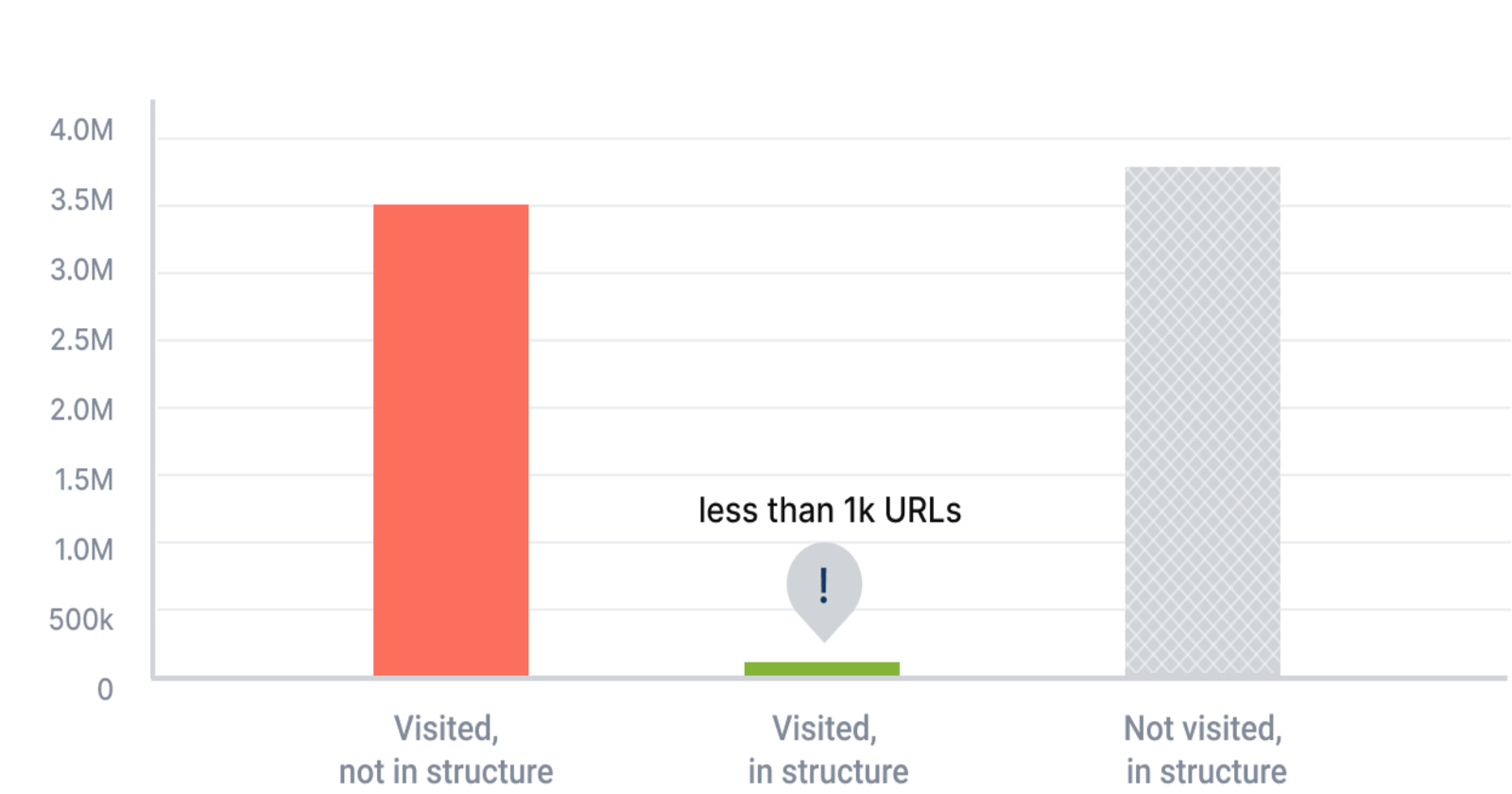

Image créée par JetOctopus, mai 2024

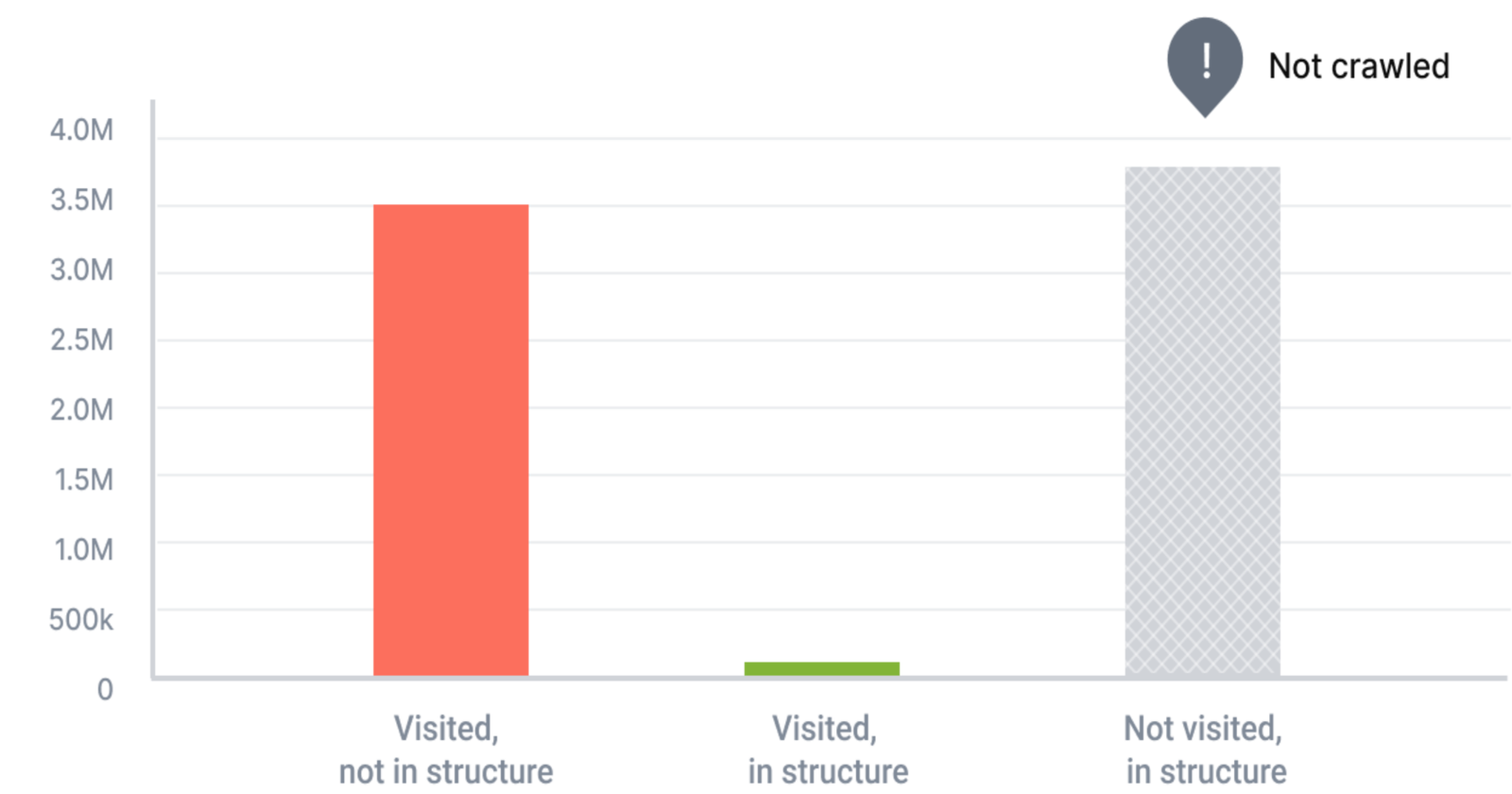

Image créée par JetOctopus, mai 2024 Comme vous pouvez le voir ci-dessus, la vue tabulaire montre combien de pages sont ouvertes à l'indexation par rapport à celles fermées à l'indexation. Comprendre ce ratio est crucial car si les pages commercialement importantes sont fermées à l'indexation, elles n'apparaîtront pas dans les étapes ultérieures de l'entonnoir.

L'étape suivante examine le nombre de pages explorées par Googlebot, les « pages vertes » représentant celles explorées et au sein de la structure, et les « pages grises » indiquant un gaspillage potentiel du budget d'exploration car elles sont visitées par Googlebot mais pas dans la structure, éventuellement des pages orphelines. ou accidentellement exclu de la structure. Il est donc essentiel d’analyser cette partie de votre budget d’exploration pour l’optimiser.

Les étapes ultérieures consistent à analyser le pourcentage de pages classées dans les SERP de Google, le nombre de ces classements figurant dans le top 10 ou les trois premiers et, enfin, le nombre de pages recevant des clics organiques.

Dans l'ensemble, l'entonnoir SEO vous donne des chiffres concrets, avec des liens vers des listes d'URL pour une analyse plus approfondie, telles que les pages indexables et non indexables et la manière dont se produit le gaspillage du budget d'exploration. Il s'agit d'un excellent point de départ pour l'analyse du budget d'exploration, permettant de visualiser la situation dans son ensemble et d'obtenir des informations pour un plan d'optimisation percutant qui génère une croissance tangible du référencement.

En termes simples, en donnant la priorité aux pages de grande valeur (en vous assurant qu'elles sont exemptes d'erreurs et facilement accessibles aux robots de recherche), vous pouvez considérablement améliorer la visibilité et le classement de votre site.

À l'aide d'un analyseur de journaux SEO, vous pouvez comprendre exactement ce qui doit être optimisé sur les pages ignorées par les robots d'exploration, travailler dessus et ainsi attirer les visites de Googlebot. Un analyseur de journaux permet d'optimiser d'autres aspects cruciaux de votre site Web :

Image créée par JetOctopus, mai 2024

Image créée par JetOctopus, mai 2024- Analyse détaillée du comportement des robots : les analyseurs de journaux vous permettent d'analyser la manière dont les robots de recherche interagissent avec votre site en examinant des facteurs tels que la profondeur de leur exploration, le nombre de liens internes sur une page et le nombre de mots par page. Cette analyse détaillée vous fournit les tâches exactes à effectuer pour optimiser les performances SEO de votre site.

- Améliore les liens internes et les performances techniques : les analyseurs de journaux fournissent des informations détaillées sur la structure et la santé de votre site. Ils aident à identifier les pages sous-performantes et à optimiser le placement des liens internes, garantissant une navigation plus fluide pour l'utilisateur et les robots d'exploration. Ils facilitent également l’ajustement du contenu pour mieux répondre aux normes SEO, tout en mettant en évidence les problèmes techniques pouvant affecter la vitesse et l’accessibilité du site.

- Aide au dépannage de JavaScript et des défis d'indexation : les grands sites Web, en particulier le commerce électronique, s'appuient souvent fortement sur JavaScript pour le contenu dynamique. Dans le cas des sites Web JS, le processus d'exploration est long. Un analyseur de journaux peut suivre dans quelle mesure les robots des moteurs de recherche sont capables de restituer et d'indexer le contenu dépendant de JavaScript, soulignant ainsi les pièges potentiels en temps réel. Il identifie également les pages qui ne sont pas indexées comme prévu, permettant ainsi des corrections en temps opportun pour garantir que tout le contenu pertinent puisse être classé.

- Aide à optimiser la distance par rapport à l'index (DFI) : le concept de distance par rapport à l'index (DFI) fait référence au nombre de clics requis pour atteindre une page donnée à partir de la page d'accueil. Un DFI inférieur est généralement meilleur pour le référencement, car cela signifie que le contenu important est plus facile à trouver, à la fois par les utilisateurs et par les robots des moteurs de recherche. Les analyseurs de journaux aident à cartographier la structure de navigation de votre site, suggérant des changements qui peuvent réduire le DFI et améliorer l'accessibilité globale du contenu clé et des pages de produits.

En outre, les données de journaux historiques proposées par un analyseur de journaux peuvent être inestimables. Cela contribue à rendre vos performances SEO non seulement compréhensibles mais également prévisibles. L'analyse des interactions passées vous permet de repérer les tendances, d'anticiper les futurs contretemps et de planifier des stratégies de référencement plus efficaces.

Avec JetOctopus, vous bénéficiez d'aucune limite de volume sur les journaux, permettant une analyse complète sans craindre de manquer des données cruciales. Cette approche est fondamentale pour affiner continuellement votre stratégie et garantir à votre site la première place dans le paysage en évolution rapide de la recherche .

Victoires du monde réel grâce à Log Analyzer

Les grands sites Web de divers secteurs ont exploité les analyseurs de journaux pour atteindre et conserver les premières places sur Google pour les mots clés rentables, ce qui a considérablement contribué à la croissance de leur entreprise.

Par exemple, Skroutz, le plus grand site Web de marché de Grèce avec plus d'un million de sessions par jour, a mis en place un outil d'exploration et d'analyse de journaux en temps réel qui l'a aidé à connaître des choses telles que :

- Googlebot explore-t-il les pages sur lesquelles plus de deux filtres sont activés ?

- Dans quelle mesure Googlebot explore-t-il une catégorie particulièrement populaire ?

- Quels sont les principaux paramètres d’URL explorés par Googlebot ?

- Googlebot visite-t-il les pages avec des filtres tels que « Taille », qui sont généralement marqués comme nofollow ?

Cette capacité à visualiser des tableaux de visualisation en temps réel et des données de journal historiques s'étalant sur dix mois pour surveiller les explorations de Googlebot a effectivement permis à Skroutz de trouver des failles d'exploration et de réduire la taille de l'index, optimisant ainsi son budget d'exploration.

Finalement, ils ont également constaté une réduction du temps d'indexation et de classement des nouvelles URL : au lieu de prendre 2 à 3 mois pour indexer et classer les nouvelles URL, la phase d'indexation et de classement n'a pris que quelques jours.

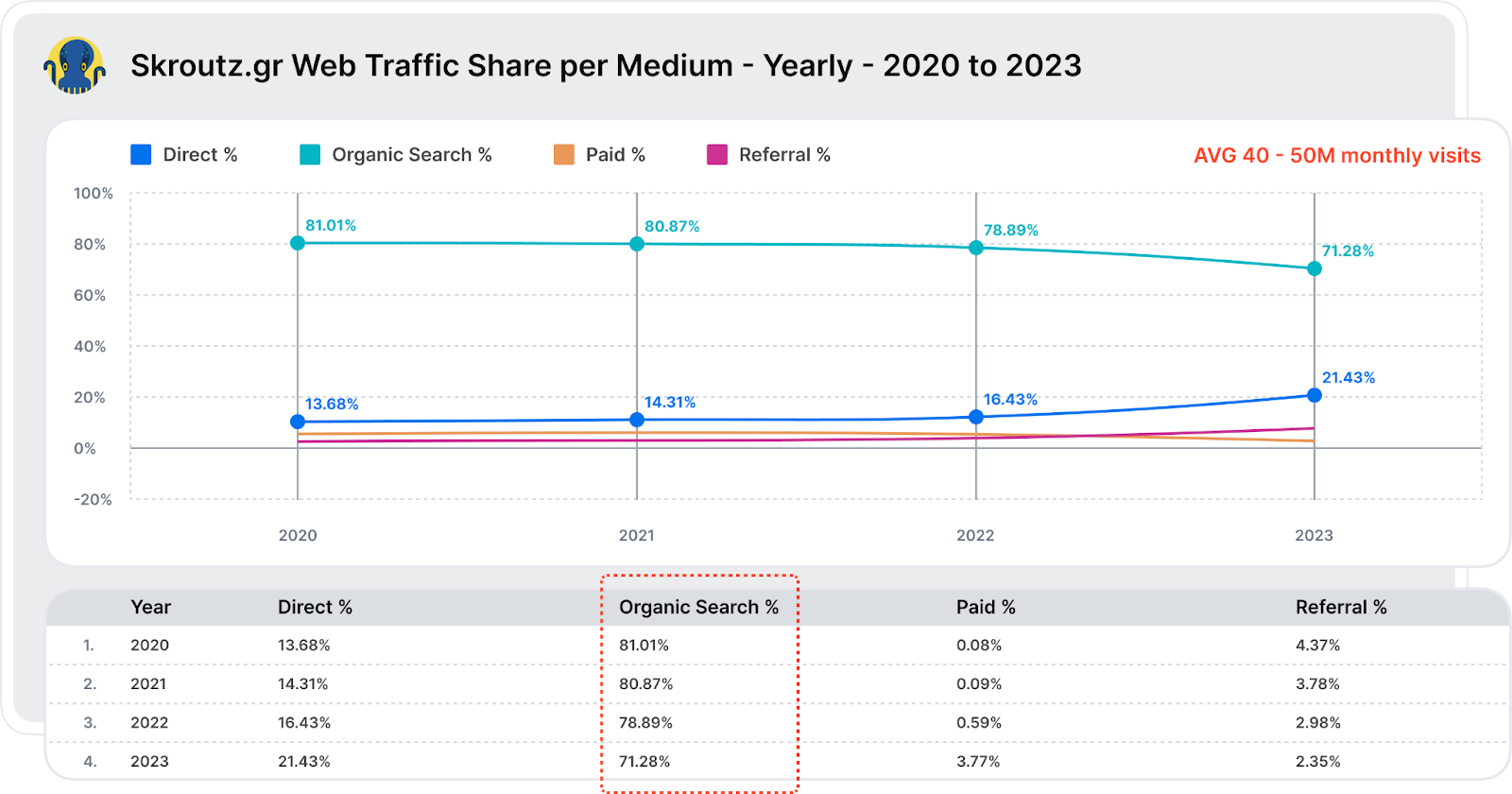

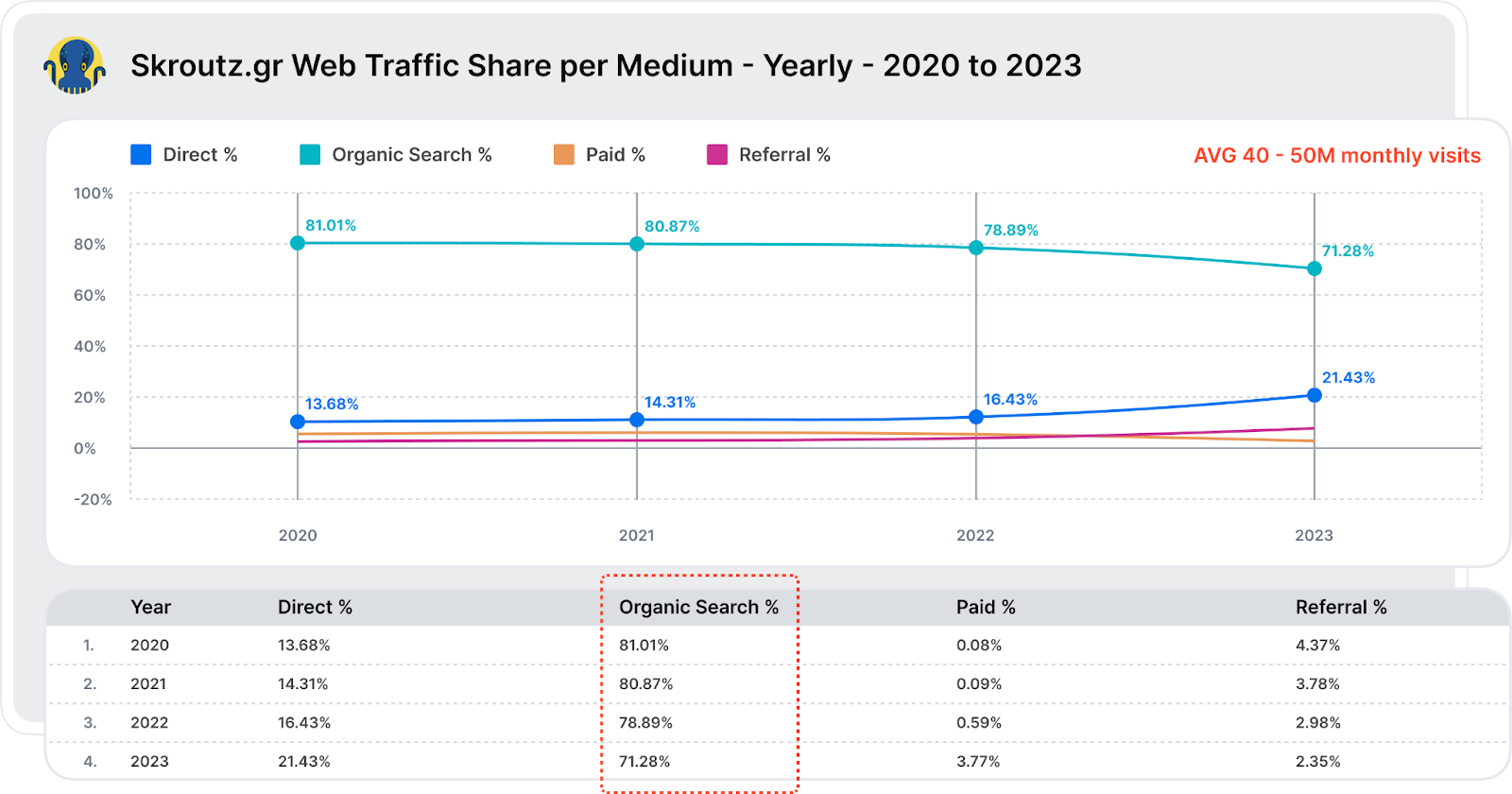

Cette approche stratégique du référencement technique utilisant des fichiers journaux a aidé Skroutz à consolider sa position parmi les 1000 meilleurs sites Web au monde selon SimilarWeb, et le quatrième site Web le plus visité en Grèce (après Google, Facebook et Youtube) avec plus de 70 % de part de marché. son trafic issu de la recherche organique.

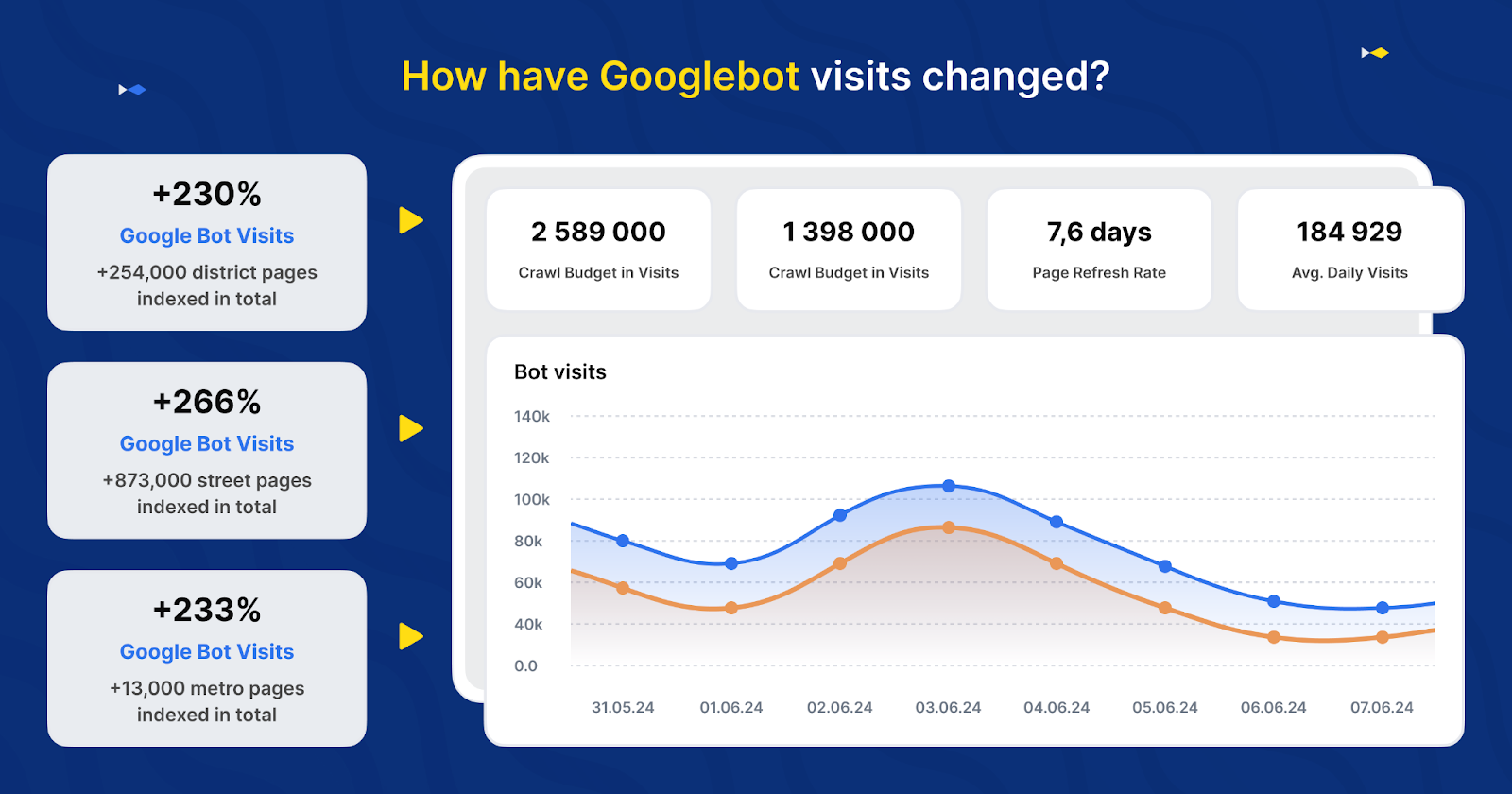

Image créée par JetOctopus, mai 2024

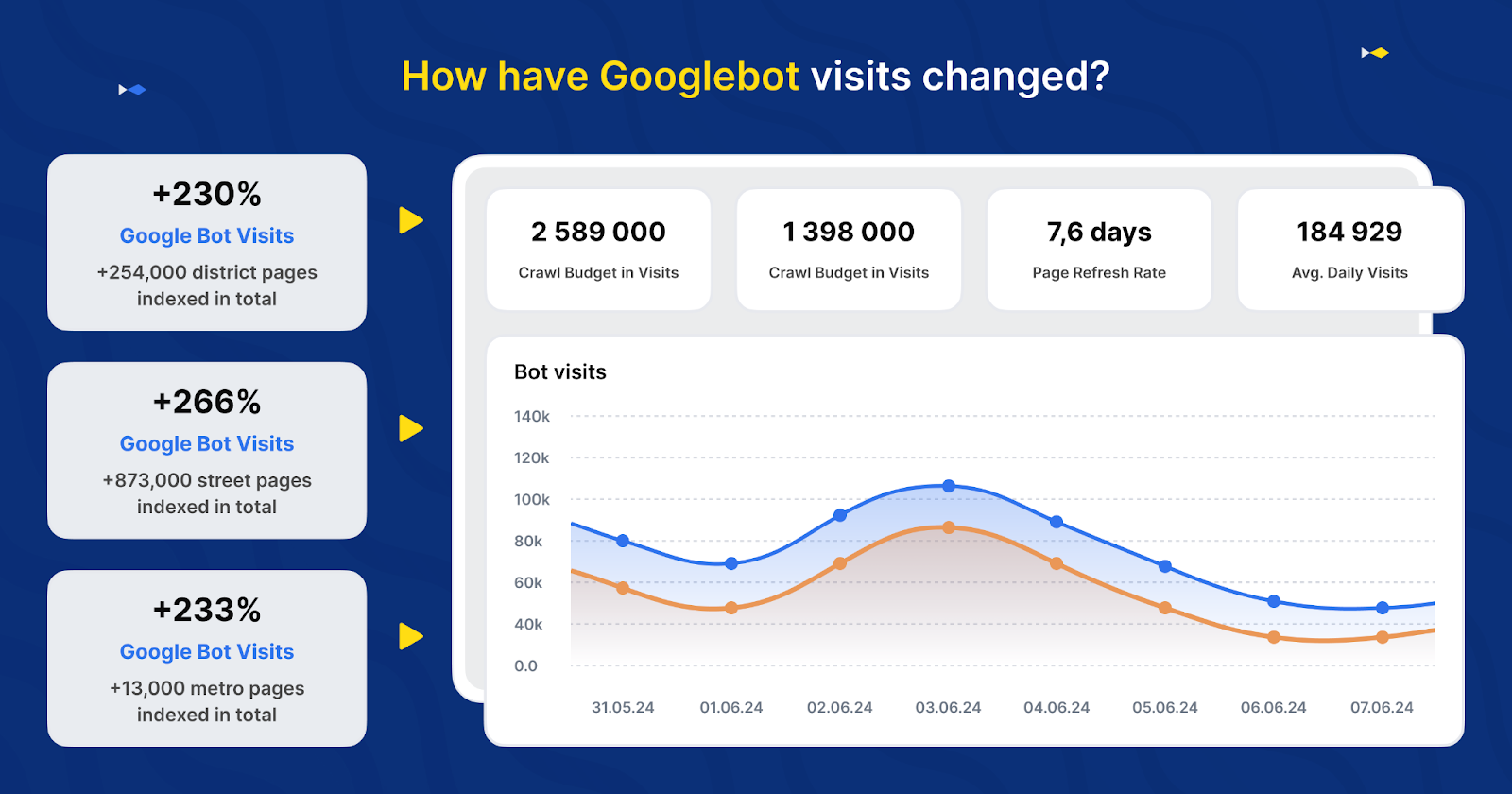

Image créée par JetOctopus, mai 2024 Un autre exemple typique est celui de DOM.RIA, le site Web ukrainien d'annonces immobilières et de locations le plus populaire, qui a doublé les visites de Googlebot en optimisant l'efficacité de l'exploration de son site Web. Comme la structure de leur site est énorme et élaborée, ils devaient optimiser l'efficacité de l'exploration de Googlebot afin de garantir la fraîcheur et la pertinence du contenu apparaissant dans Google.

Dans un premier temps, ils ont mis en œuvre un nouveau plan du site pour améliorer l'indexation des répertoires plus profonds. Malgré ces efforts, les visites de Googlebot sont restées faibles.

En utilisant JetOctopus pour analyser leurs fichiers journaux, DOM.RIA a identifié et résolu les problèmes liés à leurs liaisons internes et à DFI. Ils ont ensuite créé des mini-sitemaps pour les annuaires mal analysés (comme ceux de la ville, incluant les URL des rues, des quartiers, du métro, etc.) tout en attribuant des balises méta avec des liens vers des pages que Googlebot visite souvent. Ce changement stratégique a entraîné une multiplication par deux de l'activité de Googlebot sur ces pages cruciales en deux semaines.

Image créée par JetOctopus, mai 2024

Image créée par JetOctopus, mai 2024 Premiers pas avec un analyseur de journaux SEO

Maintenant que vous savez ce qu'est un analyseur de journaux et ce qu'il peut faire pour les grands sites Web, jetons un coup d'œil rapide aux étapes impliquées dans l'analyse des journaux.

Voici un aperçu de l'utilisation d'un analyseur de journaux SEO comme JetOctopus pour votre site Web :

- Intégrez vos journaux : commencez par intégrer les journaux de votre serveur avec un outil d'analyse des journaux. Cette étape est cruciale pour capturer toutes les données liées aux visites du site, ce qui inclut chaque requête adressée au serveur.

- Identifiez les problèmes clés : utilisez l'analyseur de journaux pour découvrir des problèmes importants tels que des erreurs de serveur (5xx), des temps de chargement lents et d'autres anomalies susceptibles d'affecter l'expérience utilisateur et les performances du site. Cette étape consiste à filtrer et trier de grands volumes de données pour se concentrer sur les problèmes à fort impact.

- Résoudre les problèmes : une fois les problèmes identifiés, hiérarchisez et résolvez ces problèmes pour améliorer la fiabilité et les performances du site. Cela peut impliquer de réparer les liens brisés, d'optimiser les pages à chargement lent et de corriger les erreurs du serveur.

- Combiner avec l'analyse d'analyse : fusionnez les données d'analyse des journaux avec les données d'analyse. Cette intégration permet une analyse plus approfondie de l'analyse et de l'optimisation du budget d'exploration. Analysez la façon dont les moteurs de recherche explorent votre site et ajustez votre stratégie de référencement pour garantir que vos pages les plus précieuses reçoivent une attention adéquate de la part des robots de recherche.

Et c’est ainsi que vous pouvez vous assurer que les moteurs de recherche indexent efficacement votre contenu le plus important.

Conclusion

Comme vous pouvez le constater, l’utilisation stratégique des analyseurs de journaux est plus qu’une simple nécessité technique pour les sites Web à grande échelle. L'optimisation de l'efficacité de l'exploration de votre site avec un analyseur de journaux peut avoir un impact considérable sur votre visibilité SERP.

Pour les directeurs marketing gérant des sites Web à grande échelle, adopter un analyseur de journaux et une boîte à outils d'exploration comme JetOctopus, c'est comme obtenir un analyste SEO technologique supplémentaire qui comble le fossé entre l'intégration des données SEO et la croissance organique du trafic.

Crédits images

Image en vedette : Image de JetOctopus utilisée avec autorisation.